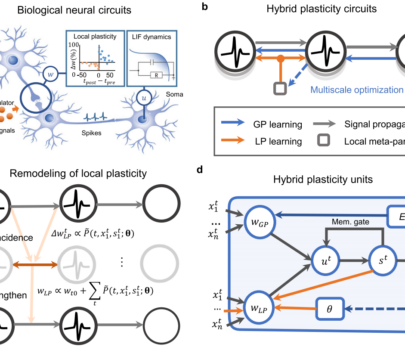

清华大学研究团队所提出的神经网络框架将神经元间的连接方式分为两部分,分别为包含下一层神经元权重和全局预测误差的wGP和基于局部神经元活动的wLP。其中θ代表超参数,用于调节神经元之间的连接,st代表记忆,能够将连续信号转为不连续的判断并最终决定该神经元的输出。

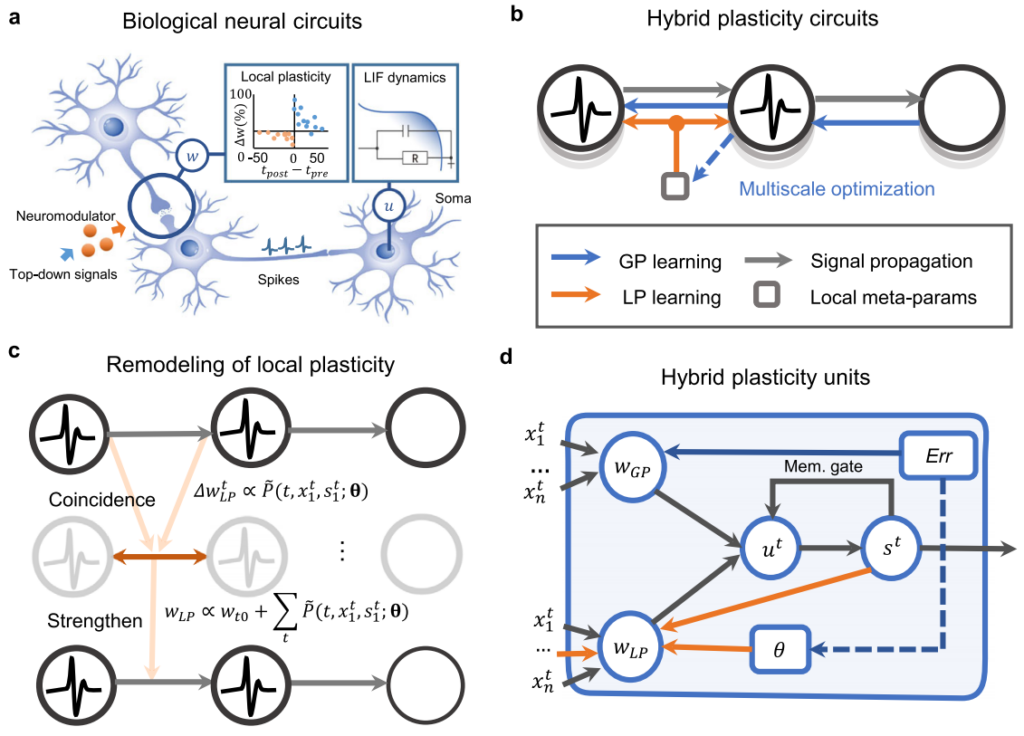

基于上述规则更新的尖峰神经网络,已被用于多种计算任务,并在曾登上 Nature 封面的天机类脑计算芯片上有对应的硬件实现。算法和硬件的协同设计充分发挥了类脑计算的多核并行优势。与现有的尖峰神经网络模型相比,混合模型在图像分类的基线任务上准确性更高,且延迟更低。在跨层级的神经元间采用不同的编码方式,可以平衡计算量与效能。这表明该方案相比传统的机器学习算法,能在相同的架构下保有更高的灵活性。与仅使用局部或全局规则更新权重的尖峰神经网络相比,混合模型的训练效果更好,收敛过程更快也更平滑。

我们通过引入一种受大脑启发的元学习范式和一个包含神经元动态和突触可塑性的可微分尖峰模型,提出了一个神经形态全局-局部协同学习模型。它能够元学习局部可塑性,并接收自上而下的监督信息进行多尺度学习。我们在多种不同任务中展示了这种模型的优势,包括少样本学习、持续学习和神经形态视觉传感器中的容错学习。它比单一学习方法实现了显著更高的性能。我们进一步在天机神经形态平台上实现了该模型,利用算法-硬件协同设计,并证明了该模型可以充分利用神经形态多核架构来发展混合计算范式。

成果发表于2022年1月10日《Nature Communications》